(от греч. entropía - поворот, превращение)

понятие, впервые введенное в термодинамике (См.

Термодинамика) для определения меры необратимого рассеяния энергии. Э. широко применяется и в других областях науки: в статистической физике (См.

Статистическая физика) как мера вероятности осуществления какого-либо макроскопического состояния; в теории информации как мера неопределенности какого-либо опыта (испытания), который может иметь разные исходы. Эти трактовки Э. имеют глубокую внутреннюю связь. Например, на основе представлений об информационной Э. можно вывести все важнейшие положения статистической физики.

В термодинамике понятие "Э." было введено Р.

Клаузиусом (1865), который показал, что процесс превращения теплоты в работу следует общей физической закономерности - второму началу термодинамики (См.

Второе начало термодинамики)

. Его можно сформулировать строго математически, если ввести особую функцию состояния - Э.

Так, для термодинамической системы, совершающей квазистатически (бесконечно медленно) циклический процесс, в котором система последовательно получает малые количества теплоты δQ при соответствующих значениях абсолютной температуры Т, интеграл от "приведенного" количества теплоты δQ/ Т по всему циклу равен нулю

(

, т. н. равенство Клаузиуса).

Это равенство, эквивалентное второму началу термодинамики для равновесных процессов, Клаузиус получил, рассматривая произвольный циклический процесс как сумму очень большого, в пределе бесконечного, числа элементарных обратимых

Карно циклов

. Математически равенство Клаузиуса необходимо и достаточно для того, чтобы выражение

dS = δQ/T (1)

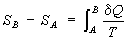

представляло собой полный дифференциал функции состояния S, названное "Э." (дифференциальное определение Э.). Разность Э. системы в двух произвольных состояниях А и В (заданных, например, значениями температур и объемов) равна

(2)

(интегральное определение Э.). Интегрирование здесь ведется вдоль пути любого квазистатического процесса, связывающего состояния А и В, при этом, согласно равенству Клаузиуса, приращение Э. ΔS = SB - SA не зависит от пути интегрирования.

Т. о., из второго начала термодинамики следует, что существует однозначная функция состояния

S, которая при квазистатических адиабатных процессах (δ

Q = 0) остаётся постоянной. Процессы, в которых Э. остаётся постоянной, называются изоэнтропийными. Примером может служить процесс, широко используемый для получения низких температур, - адиабатное размагничивание (см.

Магнитное охлаждение)

. При изотермических процессах изменение Э. равно отношению сообщенной системе теплоты к абсолютной температуре. Например, изменение Э. при испарении жидкости равно отношению теплоты испарения к температуре испарения при условии равновесия жидкости с её насыщенным паром.

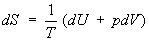

Согласно первому началу термодинамики (См.

Первое начало термодинамики) (закону сохранения энергии), δ

Q = dU+pdV, т. е. сообщаемое системе количество теплоты равно сумме приращения внутренней энергии

dU и совершаемой системой работы

pdV, где

р - давление,

V - объём системы. С учётом первого начала термодинамики дифференциальное определение Э. принимает вид

,

, (3)

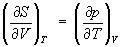

откуда следует, что при выборе в качестве независимых переменных внутренней энергии U и объёма V частные производные Э. связаны с абсолютной температурой и давлением соотношениями:

(4) и

. (5)

Формула (2) определяет Э. лишь с точностью до аддитивной постоянной (т. е. оставляет начало отсчёта Э. произвольным). Абсолютное значение Э. позволяет установить

Третье начало термодинамики, или Нернста теорему: при стремлении абсолютной температуры к нулю разность Δ

S для любого вещества стремится к нулю независимо от внешних параметров. Поэтому: Э. всех веществ при абсолютном нуле температуры можно принять равной нулю (эту формулировку теоремы Нернста предложил в 1911 М.

Планк)

. Основываясь на ней, за начальную точку отсчёта Э. принимают

So = 0 при

Т = 0.

Важность понятия Э. для анализа необратимых (неравновесных) процессов: также была показана впервые Клаузиусом. Для необратимых процессов интеграл от приведённой теплоты δQ / Т по замкнутому пути всегда отрицателен

(

, т. н. неравенство Клаузиуса).

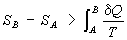

Это неравенство - следствие теоремы Карно: кпд частично или полностью необратимого циклического процесса всегда меньше, чем кпд обратимого цикла. Из неравенства Клаузиуса вытекает, что

(6)

поэтому Э. адиабатически изолированной системы при необратимых процессах может только возрастать.

Т. о., Э. определяет характер процессов в адиабатической системе: возможны только такие процессы, при которых Э. либо остаётся неизменной (обратимые процессы), либо возрастает (необратимые процессы). При этом не обязательно, чтобы возрастала Э. каждого из тел, участвующего в процессе. Увеличивается общая: сумма Э. тел, в которых процесс вызвал изменения.

Термодинамическому равновесию адиабатической системы соответствует состояние с максимумом Э. Энтропия может иметь не один, а несколько максимумов, при этом система будет иметь несколько состояний равновесия. Равновесие, которому соответствует наибольший максимум Э., называется абсолютно устойчивым (стабильным). Из условия максимальности Э. адиабатические системы в состоянии равновесия вытекает важное следствие: температура всех частей системы в состоянии равновесия одинакова.

Понятие "Э." применимо и к термодинамически неравновесным состояниям, если отклонения от термодинамического равновесия невелики и можно ввести представление о локальном термодинамическом равновесии в малых, но ещё макроскопических объёмах. Такие состояния можно охарактеризовать термодинамическими параметрами (температурой, давлением и т. д.), слабо зависящими от пространственных координат и времени, а Э. термодинамически неравновесного состояния определить как Э. равновесного состояния, характеризующегося теми же значениями параметров. В целом Э. неравновесной системы равна сумме Э. её частей, находящихся в локальном равновесии.

Термодинамика неравновесных процессов позволяет более детально, чем классическая термодинамика, исследовать процесс возрастания Э. и вычислить количество Э., образующейся в единице объёма в единицу времени вследствие отклонения системы от термодинамического равновесия -

Производство энтропии. Производство Э. всегда положительно и математически выражается квадратичной формой от градиентов термодинамических параметров (температуры, гидродинамической скорости или концентраций компонентов смеси) с коэффициентами, называемыми кинетическими (см.

Онсагера теорема)

.

Статистическая физика связывает Э. с вероятностью осуществления данного макроскопического состояния системы. Э. определяется через логарифм статистического веса (См.

Статистический вес) Ω данного равновесного состояния

S= k ln Ω (E, N), (7)

где

k - Больцмана постоянная, Ω

(

E, N)

- число квантовомеханических уровней в узком интервале энергии Δ

Е вблизи значения энергии

Е системы из

N частиц. Впервые связь Э. с вероятностью состояния системы была установлена Л.

Больцманом в 1872: возрастание Э. системы обусловлено её переходом из менее вероятного состояния в более вероятное. Иными словами, эволюция замкнутой системы осуществляется в направлении наиболее вероятного распределения энергии по отдельным подсистемам.

В отличие от термодинамики статистическая физика рассматривает особый класс процессов -

Флуктуации, при которых система переходит из более вероятного состояния в менее вероятное, и её Э. уменьшается. Наличие флуктуаций показывает, что закон возрастания Э. выполняется только в среднем для достаточно большого промежутка времени.

Э. в статистической физике тесно связана с информационной Э., которая служит мерой неопределённости сообщений данного источника (сообщения описываются множеством величин х1, x2,..., xn, которые могут быть, например, словами какого-либо языка, и соответствующих вероятностей p1, p2,..., pn появления величин x1, x2,..., xn в сообщении). Для определённого (дискретного) статистического распределения вероятностей рк информационной Э. называют величину

при условии

(8)

Значение

Ни равно нулю, если какое-либо из

pk равно 1, а остальные - нулю, т. е. неопределённость в информации отсутствует. Э. принимает наибольшее значение, когда

pk равны между собой и неопределённость в информации максимальна. Информационная Э., как и термодинамическая, обладает свойством аддитивности (Э. нескольких сообщений равна сумме Э. отдельных сообщений). К. Э.

Шеннон показал, что Э. источника информации определяет критическое значение скорости "помехоустойчивой" передачи информации по конкретному каналу связи (см.

Шеннона теорема)

. Из вероятностной трактовки информационной Э. могут быть выведены основные распределения статистической физики: каноническое

Гиббса распределение, которое соответствует максимальному значению информационной Э. при заданной средней энергии, и большое каноническое распределение Гиббса - при заданных средней энергии и числа частиц в системе.

Понятие Э., как показал впервые Э.

Шрёдингер (1944), существенно и для понимания явлений жизни. Живой организм с точки зрения протекающих в нём физико-химических процессов можно рассматривать как сложную открытую систему (См.

Открытые системы)

, находящуюся в неравновесном, но стационарном состоянии. Для организмов характерна сбалансированность процессов, ведущих к росту Э., и процессов обмена, уменьшающих её. Однако жизнь не сводится к простой совокупности физико-химических процессов, ей свойственны сложные процессы саморегулирования. Поэтому с помощью понятия Э. нельзя охарактеризовать жизнедеятельность организмов в целом.

Д. Н. Зубарев.

Э., характеризуя вероятность осуществления данного состояния системы, согласно (7) является мерой его неупорядоченности. Изменение Э. ΔS обусловлено как изменением р, V и Т, так и процессами, протекающими при р, Т = const и связанными с превращением веществ, включая изменение их агрегатного состояния, растворение и химическое взаимодействие.

Изотермическое сжатие вещества приводит к уменьшению, а изотермическое расширение и нагревание - к увеличению его Э., что соответствует уравнениям, вытекающим из первого и второго начал термодинамики (см.

Термодинамика)

:

; (9)

; (10)

. (11)

Формулу (11) применяют для практического определения абсолютного значения Э. при температуре Т, используя постулат Планка и значения теплоёмкости С, теплот и температур фазовых переходов в интервале от 0 до Т К.

В соответствии с (1) Э. измеряется в кал/(моль· К) (энтропийная единица - э. е.) и дж/(моль·К). При расчётах обычно применяют значения Э. в стандартном состоянии, чаще всего при 298,15 К (25 °С), т. е. S0298; таковы приводимые ниже в статье значения Э.

Э. увеличивается при переходе вещества в состояние с большей энергией. Δ S сублимации > ΔS парообразования >> ΔS плавления >ΔS полиморфного превращения. Например, Э. воды в кристаллическом состоянии равна 11,5, в жидком - 16,75, в газообразном - 45,11 э. е.

Чем выше твёрдость вещества, тем меньше его Э.; так, Э. алмаза (0,57 э. е.) вдвое меньше Э. графита (1,37 э. е.). Карбиды, бориды и другие очень твёрдые вещества характеризуются небольшой Э.

Э. аморфного тела несколько больше Э. кристаллического. Возрастание степени дисперсности системы также приводит к некоторому увеличению её Э.

Э. возрастает по мере усложнения молекулы вещества; так, для газов N

2О, N

2O

3 и N

2O

5 Э. составляет соответственно 52,6; 73,4 и 85,0 э. е. При одной и той же молекулярной массе Э. разветвленных углеводородов меньше Э. неразветвлённых; Э. циклоалкана (См.

Циклоалканы) (циклана) меньше Э. соответствующего ему алкен (См.

Алкены)

а. Э. простых веществ и соединений (например, хлоридов ACIn), а также её изменения при плавлении и парообразовании являются периодическими функциями порядкового номера соответствующего элемента. Периодичность изменения Э. для сходных химических реакций типа 1/n Акрист + 1/2Сl2газ = 1/n ACln крист практически не проявляется. В совокупности веществ-аналогов, например АСl4газ (А - С, Si, Ge, Sn, Pb) Э. изменяется закономерно. Сходство веществ (N2 и СО; CdCl2 и ZnCl2; Ag2Se и Ag2Te; ВаСОз и BaSiO3; PbWO4 и РЬМоО4) проявляется в близости их Э. Выявление закономерности изменения Э. в рядах подобных веществ, обусловленного различиями в их строении и составе, позволило разработать методы приближённого расчёта Э.

Знак изменения Э. при химической реакции ΔS

х. р. определяется знаком изменения объёма системы ΔV

х. р.; однако возможны процессы (изомеризация, циклизация), в которых ΔS

х. р. ≠ 0, хотя ΔV

х. р. ≈ 0. В соответствии с уравнением ΔG = ΔН - ТΔS (G -

Гиббсова энергия, Н - Энтальпия) знак и абсолютное значение ΔS

х. р. важны для суждения о влиянии температуры на

Равновесие химическое. Возможны самопроизвольные экзотермические. процессы (ΔG < 0, ΔH < 0), протекающие с уменьшением Э. (ΔS < 0). Такие процессы распространены, в частности, при растворении (например, комплексообразование), что свидетельствует о важности химических взаимодействий между участвующими в них веществами.

М. X. Карапетьянц.

Лит.: Клаузиус P., в кн.: Второе начало термодинамики, М.-Л., 1934, с. 71-158; Зоммерфельд А., Термодинамика и статистическая физика, пер. с нем., М., 1955; Майер Дж., Гепперт-Майер М., Статистическая механика, пер. с англ., М., 1952; Де Гроот С., Мазур П., Неравновесная термодинамика, пер. с англ., М., 1964; Зубарев Д. Н., Неравновесная статистическая термодинамика, М., 1971; Яглом А. М., Яглом И. М., Вероятность и информация, 3 изд., М., 1973; Бриллюен Л., Наука и теория информации, пер. с англ., М., 1959. См. также лит. при ст.

Термодинамика, Термодинамика неравновесных процессов и

Статистическая физика.